HBM: Het strategische knelpunt onder de wereldwijde AI-infrastructuur

De snelle opmars van artificiële intelligentie wordt vaak beschreven als een wedloop in rekenkracht. In de praktijk ligt het echte knelpunt echter niet bij de processor zelf, maar bij het geheugen dat deze processor moet voeden. High Bandwidth Memory, beter bekend als HBM, is uitgegroeid tot een essentiële bouwsteen onder vrijwel elke moderne AI-architectuur.

Wil je alle artikelen kunnen lezen en elke podcast beluisteren? Neem dan een abonnement en krijg toegang tot alle artikelen en de database met duizenden berichten.

Zonder voldoende HBM kunnen geavanceerde GPU’s en AI-accelerators hun prestaties niet benutten. De snelheid waarmee data tussen geheugen en rekenkern beweegt, bepaalt in toenemende mate de efficiëntie, schaalbaarheid en economische haalbaarheid van AI-systemen. Hierdoor is HBM verschoven van een ondersteunend component naar een strategische beperkende factor binnen de halfgeleiderketen.

De huidige marktstructuur wordt gekenmerkt door een explosieve groei in vraag, terwijl het aanbod beperkt blijft tot een zeer klein aantal producenten. Dit spanningsveld vormt de kern van de strategische waarde van HBM.

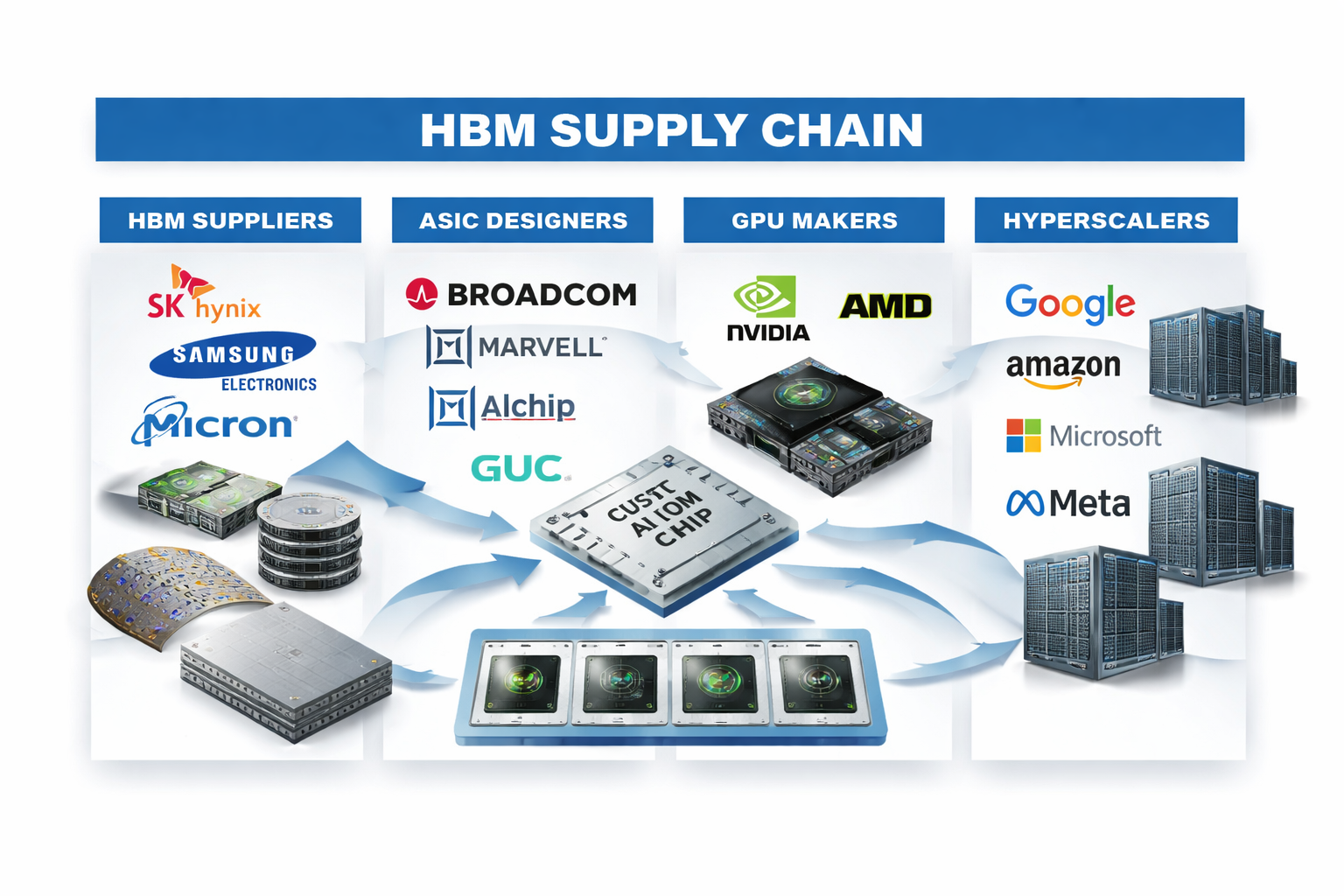

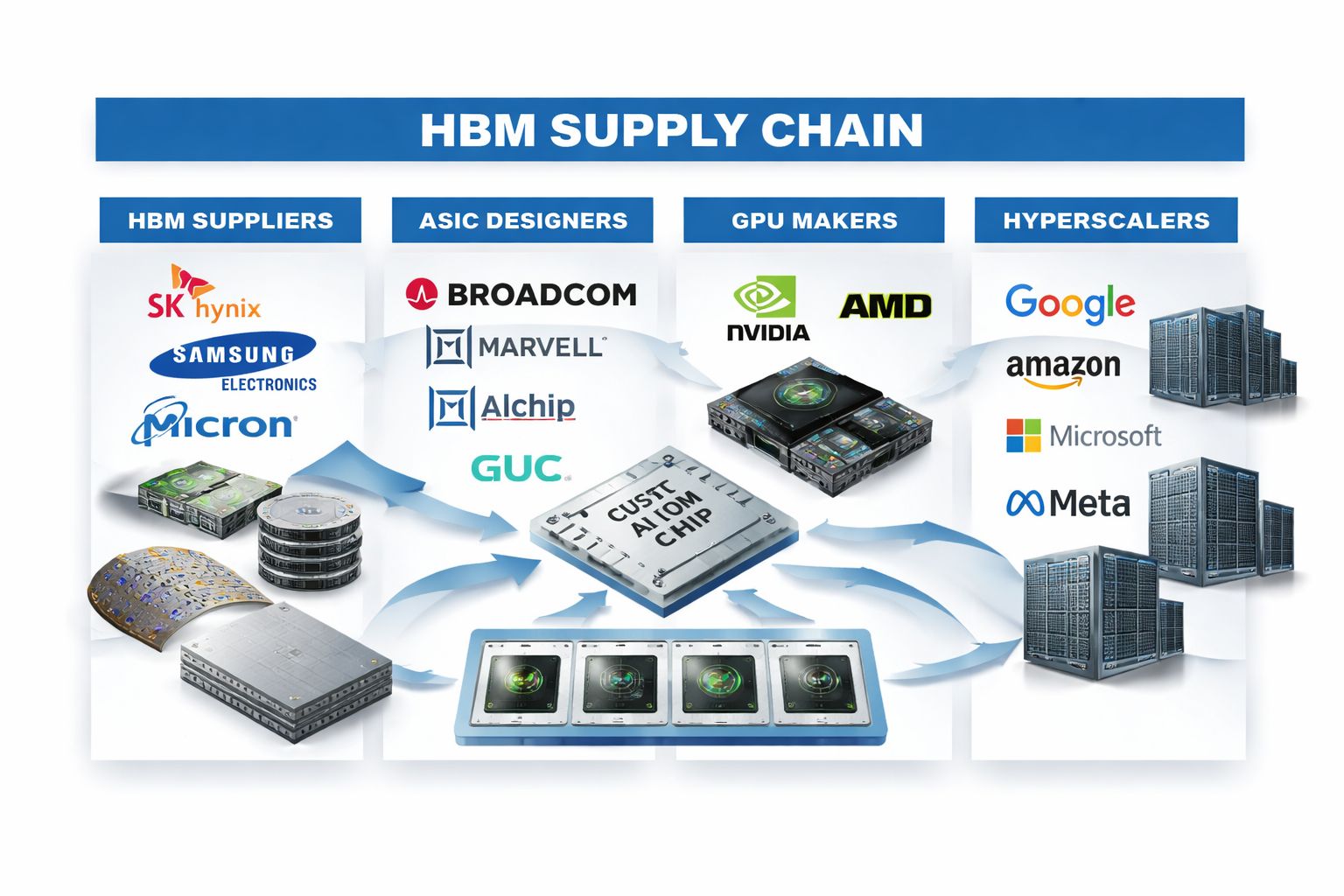

- Slechts drie bedrijven produceren HBM op schaal: SK Hynix, Samsung Electronics en Micron (dat hebben we op uitstekende niveaus gekocht, zie de database)

- Grote afnemers zijn GPU-ontwikkelaars zoals NVIDIA en AMD

- Hyperscalers ontwikkelen eigen AI-chips, waaronder Google (TPU), Amazon (Trainium en Inferentia), Microsoft (Maia) en Meta (MTIA)

- ASIC-ontwerpers zoals Broadcom, Marvell, Alchip en GUC vormen de verbindende schakel

- De beschikbaarheid van HBM bepaalt direct hoeveel AI-chips daadwerkelijk geleverd kunnen worden

Wat is HBM en waarom is het onmisbaar voor AI

HBM is een vorm van geavanceerd DRAM-geheugen waarbij meerdere geheugenlagen verticaal op elkaar worden gestapeld. Deze lagen zijn via microscopische verbindingen direct met elkaar verbonden en worden dicht bij de rekenchip geplaatst via geavanceerde packaging-technologie.

Dit ontwerp levert een extreem hoge geheugenbandbreedte, aanzienlijk lagere latency en een gunstiger energieverbruik per verwerkte databit. Voor AI-workloads, die bestaan uit massale parallelle berekeningen en continue datastromen, is deze combinatie essentieel.

Zonder HBM ontstaat er een dataknelpunt. Zelfs de krachtigste GPU wacht dan op data, waardoor prestaties wegvallen en de efficiëntie verslechtert. In die zin is HBM geen prestatieverbeteraar, maar een noodzakelijke randvoorwaarde voor moderne AI-systemen.

Geconcentreerde markt met structurele schaarste

De productie van HBM behoort tot de meest complexe processen in de halfgeleiderindustrie. Het vereist niet alleen geavanceerde DRAM-technologie, maar ook diepgaande kennis van stacking, yield-management, thermische stabiliteit en nauwe samenwerking met packaging-partners.

SK Hynix heeft zich ontwikkeld tot de technologische koploper binnen HBM en is diep geïntegreerd in de AI-roadmaps van grote chipontwikkelaars. Samsung Electronics beschikt over enorme schaal en brede productiecapaciteit, maar moet bij HBM continu balanceren tussen volume en rendement. Micron bevindt zich in een inhaalslag en richt zich nadrukkelijk op het opvoeren van capaciteit in de hogere HBM-segmenten.

Capaciteitsuitbreiding kost jaren. Nieuwe fabrieken vergen enorme investeringen en lange optimalisatietrajecten voordat zij stabiel op hoog volume kunnen draaien. Hierdoor groeit het aanbod structureel langzamer dan de vraag, wat HBM tot een schaars en strategisch goed maakt.

De vraagzijde: GPU’s en AI-accelerators

Aan de vraagkant zijn vooral GPU-ontwikkelaars zoals NVIDIA en AMD afhankelijk van HBM. Hun AI-platformen combineren duizenden rekenkernen met meerdere HBM-stacks om voldoende data gelijktijdig te verwerken.

Voor deze bedrijven geldt dat elke nieuwe generatie chips meer geheugen vereist dan de vorige. Meer rekenkracht betekent automatisch een grotere vraag naar bandbreedte en dus naar HBM. De beschikbaarheid van geheugen bepaalt daarmee direct de productievolumes en omzetgroei.

Daarnaast bestaat er vraag vanuit gespecialiseerde AI-chips, waaronder oplossingen gericht op specifieke markten en regio’s, wat de druk op beschikbare capaciteit verder vergroot.

De middenlaag: ASIC-ontwerpers als strategische schakels

Tussen geheugenproducenten en eindklanten bevindt zich een cruciale, maar vaak minder zichtbare laag: de ASIC-ontwerpers. Bedrijven zoals Broadcom, Marvell, Alchip en GUC ontwerpen maatwerk-AI-chips voor grote klanten en hyperscalers.

Deze partijen bepalen hoe HBM wordt geïntegreerd in een chipontwerp. Het aantal geheugenstacks, de configuratie van datapaden en de balans tussen prestaties en energieverbruik worden hier vastgelegd. Kleine ontwerpkeuzes kunnen grote gevolgen hebben voor zowel prestaties als de totale HBM-behoefte.

Door de verschuiving richting custom silicon groeit de strategische rol van deze ontwerpers snel. Zij vormen de schakel tussen geheugenleveranciers, foundries en eindgebruikers.

Hyperscalers en verticale integratie

Grote cloudbedrijven ontwikkelen steeds vaker hun eigen AI-chips om kosten te beheersen en hun infrastructuur te optimaliseren. Google doet dit met TPU’s, Amazon met Trainium en Inferentia, Microsoft met Maia en Meta met MTIA.

Hoewel de architecturen verschillen, delen deze chips één gemeenschappelijke factor: een zware afhankelijkheid van HBM. Hierdoor concurreren hyperscalers direct met GPU-leveranciers om dezelfde schaarse geheugenresources. Dit vergroot de strategische waarde van langdurige leveringsrelaties en versterkt de machtspositie van HBM-producenten.

Conclusie

HBM is uitgegroeid tot het stille fundament onder de wereldwijde AI-infrastructuur. Waar de aandacht vaak uitgaat naar GPU’s, modellen en software, ligt de echte schaarste bij het geheugen dat deze systemen voedt. De combinatie van technische complexiteit, beperkte productiecapaciteit en explosieve vraag maakt HBM tot een bepalende factor binnen de halfgeleiderindustrie.

Voor de komende jaren geldt een eenvoudige realiteit. Wie toegang heeft tot HBM, kan opschalen. Wie die toegang mist, blijft achter, ongeacht de kwaliteit van de rekenchip. Daarmee is HBM niet alleen een technisch knelpunt, maar ook een strategisch machtsmiddel binnen de wereldwijde AI-keten.

🔵 English version

HBM: the structural bottleneck beneath the global AI infrastructure

The rapid rise of artificial intelligence is often framed as a race for raw compute power. In practice, the true bottleneck no longer sits inside the processor itself, but in the memory subsystem feeding that processor. High Bandwidth Memory, commonly referred to as HBM, has become a foundational component across virtually every modern AI architecture.

Without sufficient HBM capacity, advanced GPUs and AI accelerators cannot operate at their intended performance levels. The speed at which data moves between memory and compute increasingly determines efficiency, scalability, and economic viability. As a result, HBM has shifted from a supporting component to a strategic constraint within the semiconductor value chain.

The current market structure is defined by explosive demand growth against an extremely limited supply base. That imbalance is the core source of HBM’s strategic importance.

- Only three companies manufacture HBM at scale: SK Hynix, Samsung Electronics, and Micron

- Primary buyers include GPU developers such as NVIDIA and AMD

- Hyperscalers are building proprietary AI chips, including Google (TPU), Amazon (Trainium and Inferentia), Microsoft (Maia), and Meta (MTIA)

- ASIC designers such as Broadcom, Marvell, Alchip, and GUC act as the critical integration layer

- HBM availability directly caps how many AI chips can be produced and shipped

What HBM is and why it is indispensable for AI

HBM is an advanced form of DRAM in which multiple memory dies are vertically stacked and interconnected through microscopic vias. These stacks are placed in close proximity to the compute die using advanced packaging technologies.

This architecture delivers exceptionally high memory bandwidth, materially lower latency, and improved energy efficiency per bit transferred. For AI workloads characterized by massive parallelism and continuous data movement, this combination is non-negotiable.

Without HBM, data becomes the bottleneck. Even the most powerful processors stall while waiting for memory access, degrading performance and efficiency. In this context, HBM is not an accelerator, but a prerequisite for modern AI systems.

The supply side: a highly concentrated market with structural scarcity

HBM manufacturing represents one of the most complex processes in the semiconductor industry. It requires not only advanced DRAM technology, but also deep expertise in die stacking, yield optimization, thermal management, and tight coordination with advanced packaging partners.

SK Hynix has emerged as the technology leader in HBM and is deeply embedded in the AI roadmaps of leading chip developers. Samsung Electronics brings unmatched scale and manufacturing breadth but must continuously balance volume with yields in HBM production. Micron is in catch-up mode, aggressively expanding capacity in higher-end HBM segments.

Capacity expansion is slow and capital-intensive. New fabs require years of investment and optimization before reaching stable high-volume output. As a result, supply growth structurally lags demand, reinforcing HBM’s scarcity and strategic value.

The demand side: GPUs and AI accelerators

On the demand side, GPU developers such as NVIDIA and AMD are heavily dependent on HBM. Their AI platforms combine thousands of compute cores with multiple HBM stacks to sustain data throughput.

Each successive chip generation requires more memory than the last. More compute inherently drives higher bandwidth requirements, translating directly into increased HBM consumption. Memory availability therefore becomes a direct limiter on production volumes and revenue growth.

In parallel, demand also comes from specialized AI accelerators targeting specific workloads and regions, adding further pressure on constrained capacity.

The middle layer: ASIC designers as strategic enablers

Between memory producers and end customers sits a critical but often underappreciated layer: ASIC designers. Companies such as Broadcom, Marvell, Alchip, and GUC design custom AI silicon for hyperscalers and large enterprises.

These firms define how HBM is integrated into chip architectures, including stack count, memory topology, and the performance-to-power trade-off. Small architectural decisions can materially affect both performance outcomes and total HBM requirements.

As the industry shifts toward custom silicon, the strategic importance of these designers continues to grow. They serve as the connective tissue linking memory suppliers, foundries, and end users.

Hyperscalers and accelerating vertical integration

Large cloud providers are increasingly developing in-house AI chips to control costs and tailor infrastructure to specific workloads. Google does this with TPUs, Amazon with Trainium and Inferentia, Microsoft with Maia, and Meta with MTIA.

Despite architectural differences, these chips share one common dependency: heavy reliance on HBM. As a result, hyperscalers now compete directly with GPU vendors for the same limited memory resources. This dynamic elevates the importance of long-term supply agreements and further strengthens the strategic position of HBM manufacturers.

Conclusion

HBM has become the silent foundation of the global AI infrastructure. While market attention often focuses on GPUs, models, and software, the true scarcity lies in the memory feeding these systems. Technical complexity, limited manufacturing capacity, and explosive demand have positioned HBM as a decisive factor in the semiconductor ecosystem.

Looking ahead, the reality is straightforward. Those with secured access to HBM can scale. Those without it will fall behind, regardless of compute capability. In that sense, HBM is not merely a technical bottleneck, but a strategic control point in the global AI value chain.

Disclaimer Aan de door ons opgestelde informatie kan op geen enkele wijze rechten worden ontleend. Alle door ons verstrekte informatie en analyses zijn geheel vrijblijvend. Alle consequenties van het op welke wijze dan ook toepassen van de informatie blijven volledig voor uw eigen rekening.

Wij aanvaarden geen aansprakelijkheid voor de mogelijke gevolgen of schade die zouden kunnen voortvloeien uit het gebruik van de door ons gepubliceerde informatie. U bent zelf eindverantwoordelijk voor de beslissingen die u neemt met betrekking tot uw beleggingen.